Mis à jour le 31/03/2025

En informatique, le crawl, signifiant littéralement “ramper” en anglais, est l’action d’explorer un site web, page après page, lien après lien. On parle de crawl uniquement pour les algorithmes, et non pour les internautes, qui ne font que naviguer. À cet égard, une des principales différences réside dans la vitesse d’exécution ; le crawl ne nécessite qu’une infime fraction de seconde pour un bot.

Ainsi, les crawlers (ou spiders) sont des programmes spécialisés dans la visite ultra-rapide de sites web, ce qui permet aux moteurs de recherche de les analyser avant de les ranger dans leur index en récupérant leur code source. C’est donc une étape indispensable pour qu’un site web apparaisse dans les pages de résultats de recherche (ou SERP).

Nota Bene : il existe des logiciels de crawl à exploiter pour le référencement naturel et autres stratégies de présence digitale.

Quels sont les principaux types de crawlers ?

On peut distinguer trois grandes catégories de crawlers :

- les crawlers d’exploration (ou d’indexation), évoqués en préambule, à savoir ceux qu’utilisent les moteurs de recherche. On appelle Googlebot et Bingbot les crawlers des deux moteurs les plus utilisés dans le monde. Ils ont la même fonction, à savoir de parcourir des milliards de pages web pour actualiser leurs index respectifs ;

- les crawlers de diagnostic, notamment utilisés par les experts en référencement pour auditer un site à optimiser, en analysant sa structure, l’accès aux pages, le nombre et la qualité des backlinks, la durée de chargement, le duplicate content, etc.. Il existe aujourd’hui plein d’outils super performants à disposition des travailleurs SEO. Les plus connus sont Oncrawl, Deep Crawl, Screaming Frog, SEMRush ou encore Botify.

- les crawlers de veille, qui vont permettre d’aller chercher certaines informations sur d’autres sites web, en particulier les données tarifaires dans le cadre du e-commerce. Ce peut également être pour collecter d’autres données comme des adresses e-mails ou des parcours utilisateurs. C’est ce que l’on nomme le datamining.

Mais voyons un peu plus avant comment fonctionnent les spiders des moteurs de recherche !

Comment fonctionne un robot crawler de Google (ou autre) ?

La mission des crawlers d’indexation consiste à passer et repasser en revue une énorme partie du World Wide Web, afin d’alimenter l’index du moteur de recherche qui les utilise. Ils vont déjà prioriser une partie des sites et pages à explorer en fonction de critères spécifiques. Ainsi, toutes les ressources du web ne sont pas crawlées avec la même assiduité.

Au cours de l’exploration, les bots vont sauvegarder les codes HTML des pages a priori les plus pertinentes pour les étudier ultérieurement. Ils retiennent également les liens hypertextes présents sur chaque site web afin de voir vers quelles ressources pointent ces redirections, et si elles peuvent également avoir un intérêt pour les internautes.

Une fois toutes les informations traitées, toutes les pages mémorisées vont intégrer l’index du moteur de recherche. Cette gigantesque archive sera alors prête à ressortir en suggestion, classées par ordre de pertinence, les URLs recueillies au moindre mot-clé saisi en barre de recherche et correspondant à leur contenu.

Et cela en continu en allant quotidiennement à la pêche aux mises à jour (nouvelle publication, refonte, etc.) sur l’ensemble des sites figurant dans l’index, afin de proposer aux visiteurs les pages web les plus fraîches possibles.

En résumé, le processus ressemble à ceci :

- sélection et exploration des pages, en fonction des critères définis par le moteur (taille du site, mises à jour fréquentes, etc.). Les bots passent par les URLs de chaque page, examinent le code HTML et analysent tous les éléments du document proposé (titres, sous-titres, texte, les métadonnées, images, liens, etc.) ;

- mise en mémoire des URL des pages et indexation des données collectées afin que la page puisse être proposée aux internautes en fonction des mots-clés saisis. Les données sont organisées pour être accessibles le plus rapidement possible dans les SERPs, notamment par le biais des featured snippets et le classement par ordre de pertinence ;

- vérification des mises à jour sur les pages web connues, afin que l’index ne propose pas de ressources obsolètes ;

- suivi des liens hypertexte pour accéder aux prochaines pages afin de parcourir le réseau tissé par le maillage interne et par les liens sortants vers des sites tiers. Plus il y a de bots qui passent par ces liens, plus il y a de transfert de linkjuice !

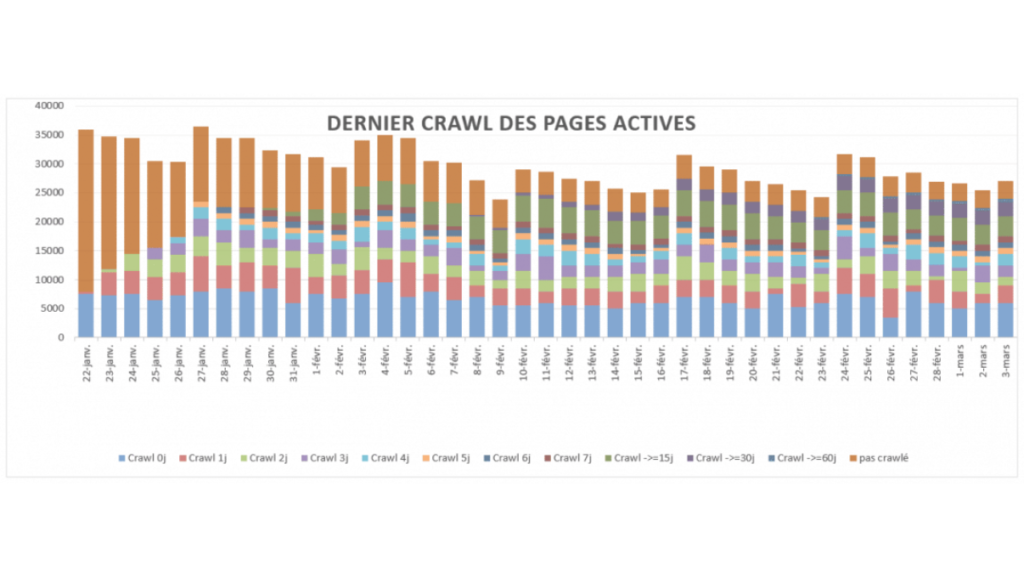

Combien de fois les spiders crawlent-ils mon site web ?

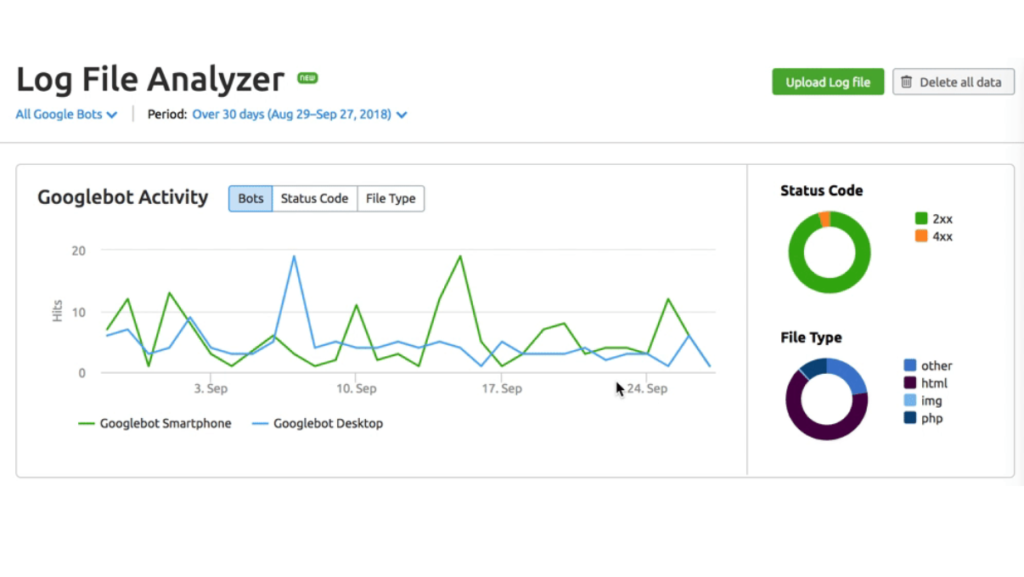

Pour obtenir cette information, il s’agit de procéder à une analyse de logs. Seulement, cette opération est relativement compliquée, qui requiert l’intervention d’un expert en référencement. Voici néanmoins quelques points à connaître pour y voir plus clair.

Le budget de crawl : ne pas l’épuiser inutilement !

Même s’il est surpuissant, le système algorithmique de Google comporte des limites. C’est pourquoi il attribue un budget crawl à chacun des sites, plus ou moins conséquent, notamment selon :

- sa note de pagerank interne ;

- son degré de popularité ;

- ses performances techniques (ex : vitesse de chargement) ;

- la profondeur des pages ;

- la fraîcheur des publications.

Peu importe le budget alloué à votre site web, il convient d’éviter de l’épuiser avec des pages inutiles (erreurs 404, duplicate content, contenus à faible valeur ajoutée et autres spider traps) ou orphelines (hors structure ou no match, c’est-à-dire qu’aucun chemin n’existe pour y accéder depuis la page d’accueil). Il peut s’agir de pages expirées ou provenant d’anciennes versions du site et mal redirigées, ou simplement d’URLs mal renseignées dans votre sitemap.

La fréquence de crawl : pas tous logés à la même enseigne !

La fréquence de crawl, c’est tout simplement le nombre de fois qu’un site est visité par les bots des moteurs de recherche sur une période donnée. Certaines pages très populaires vont pouvoir être crawlées plusieurs dizaines de fois par jour, tandis que d’autres ne verront pas le moindre bot pendant une semaine, voire davantage. À cet égard, Google utilise des critères fondés sur le comportement des utilisateurs pour voir quels contenus sur internet doivent faire l’objet de vérifications très régulières.

Nota Bene : la fenêtre de crawl est la fréquence de crawl requise pour qu’une page web devienne active, c’est-à-dire qu’elle accueille au moins un visiteur organique. Cette fenêtre dépend, bien entendu, de la popularité du site en question.

Crawl et SEO : en quoi les deux sont-ils liés ?

Le plus élémentaire à comprendre est que sans spider pour crawler une page web, nul indexation n’est possible. Et pas d’indexation, pas d’apparition dans les pages de résultats de recherche.

En second lieu il convient de se représenter que le crawl constitue déjà une première étape dans la classification, car c’est à ce moment que les bots peuvent observer :

- la structure de votre site web, et la cohérence dans l’arborescence des pages (et ce notamment à travers votre maillage interne) ;

- la profondeur de chaque page (qui correspond aux nombres de clics minimums nécessaire pour l’atteindre à partir de la page d’accueil, dont la profondeur est de facto 0) ;

- les liens hypertextes entrants (backlinks) et sortants vers d’autres sites, et la pertinence des ressources avec lesquelles votre site web est donc mis en relation ;

Or, ces trois points font partie des facteurs essentiels pour le ranking. Ainsi, lorsque vous organisez l’architecture de votre site web et que vous vous attelez à votre netlinking (maillage interne + stratégie de backlinks), gardez à l’esprit de vouloir fluidifier le travail des spiders, ne serait-ce que pour optimiser votre budget crawl, mais aussi potentiellement gagner de précieuses places dans les SERPs.

Comment et pourquoi faciliter le crawl de Googlebot, Bingbot, et cie ?

En fait, chaque site internet dispose d’un budget crawl, car malgré la vitesse impressionnante des bots, il leur faut économiser le plus de temps possible pour tenir compte de la colossale masse d’information mise en ligne quotidiennement. Ainsi, chaque passage sur votre site est limité en temps et en requêtes DNS. Tous les sites ne disposent pas du même budget, mais les plus populaires sont avantagés.

Quelle que soit la notoriété du vôtre, votre objectif sera d’optimiser votre budget crawl en rendant votre domaine “crawler-friendly”. L’idée est de tout faire pour alléger la tâche des bots d’exploration. Pour cela, voici quelques astuces courantes :

- rendre vos pages les plus accessibles possible, avec une structure en silos thématique et une arborescence logique. Concernant la profondeur, tentez de suivre la règle des 3 clics maximum depuis la page d’accueil ;

- optimiser votre maillage interne en tenant compte de la structure de votre site web (évitez les boucles et les pages thématiquement éloignées). Attention aux redirections inutiles ;

- placer des liens externes vers des sites pertinents. Utilisez la balise rel=nofollow si vous préférez ne pas distribuer de linkjuice à la page de destination, et la balise rel=sponsored pour les hyperliens que l’on vous a achetés. Attention aux liens morts ;

- générer un sitemap.xml pour lister l’ensemble des URLs de votre site web et leurs interconnexions, puis soumettez-le à la Search Console ;

- utiliser des fichiers robots.txt ou la balise “noindex” pour demander aux bots de ne pas explorer ou indexer des pages ou des sections entières de votre domaine

- avoir des URLs uniformes et éviter le duplicate content, car les redondances sont souvent mal perçues par les crawlers. Si malgré tout vous avez des pages trop proches dans leur URL ou leur contenu, les balises canoniques vous permettent d’indiquer quelle est la page principale, donc celle à indexer ;

- vérifier vos temps de chargement. Si besoin, réduisez la taille des images avec un format WebP ou des outils de compression de vos fichiers CSS, JavaScript et HTML. Choisissez un hébergeur web efficace et utilisez un CDN si besoin de booster votre bande passante.

Utilisez vous-même des crawlers pour votre référencement !

Bien sûr, plus votre site est grand, plus vous allez vous-même avoir besoin d’utiliser un crawler afin d’identifier toutes les problématiques à anticiper et à corriger pour fluidifier et le travail d’indexation en amont et, en aval, la navigation de vos visiteurs. Couplés à une analyse de logs, qui permet notamment de suivre l’activité des spiders de Google, de Bing, etc., vous aurez une vision complète de vos besoins SEO.

Nota Bene : ne pas confondre ces outils avec les “scrapers”, qui servent à extraire de la donnée d’un site web.

Quelques exemples de crawlers au service du SEO

Dans la catégorie des crawlers gratuits, on peut citer Xenu, LinkExaminer ou Free SEO Toolkit. Tous ont la capacité de vérifier vos backlinks, liens brisés, pages noindex ou redirections en no follow. Parfois, vous avez des fonctionnalités annexes comme le rapport sur la profondeur des pages, le poids de vos images, la détection de pages dupliquées, etc.

Quant aux crawlers payants, ils sont bien évidemment plus avancés. On recommandera sans hésiter :

- Screaming Frog vous laisse tester gratuitement 500 urls avant de vous facturer. Il permet l’audit complet de n’importe quel site web à extraire sur fichier Excel ;

- Deep crawl, spécialisé dans l’analyse approfondie de la qualité des backlinks avec des outils de mesure spécifiques ;

- SEMrush, particulièrement efficace en ce qui concerne la recherche de mots-clés, mais également trouver des opportunités de backlinks ;

- Botify permet de procéder à une analyse de logs ;

- Oncrawl également, qui présente ses rapports sous forme d’infographies plus lisibles que Screaming Frog ;

Pour finir…

Les crawlers représentent une dimension primordiale du web, dont dépend tout bonnement la visibilité d’une page auprès des internautes. Pour rendre une page attractive, il convient de respecter quelques pratiques fondamentales comme publier régulièrement du contenu qualitatif pour inciter au crawl, ficeler la structure d’un site via un maillage interne cohérent, augmenter ses backlinks de qualité, etc.

À ce titre, vous pouvez réaliser une veille sur les évolutions des algorithmes des moteurs de recherche afin de prendre de vitesse les autres acteurs de votre secteur d’activité. Le reste du temps, gardez en priorité l’expérience de navigation des utilisateurs !

En outre, il sera rapidement indispensable de faire appel à un crawler indépendant des moteurs de recherche afin de nettoyer le site de toutes les erreurs qui peuvent ralentir les Googlebots ou les Bingbots… non sans vous faire accompagner par un consultant SEO !