Mis à jour le 10/03/2025

Un algorithme consiste en un système mathématique dont la fonction est d’établir un ensemble de règles afin de résoudre un certain type de problème de manière automatisée. En ce qui concerne les moteurs de recherche, et plus particulièrement Google, les algorithmes ont pour objectif de faire remonter dans les pages de résultats de recherche les publications les plus pertinentes en fonction d’un mot (ou plusieurs) choisi(s) par l’utilisateur pour sa requête.

Pour cela, tout le système algorithmique du géant de la Mountain View a appris à chercher parmi des milliards de sites web les réponses les plus proches de n’importe quelle intention de recherche, à travers une infinité de mots-clés possibles, en tenant compte de centaines de critères plus ou moins importants, comme la qualité du contenu, le temps de chargement ou encore les liens qui renvoient à la page en question.

En conséquence, connaître, ne serait-ce qu’un peu, les principales fonctions des robots de Google aide considérablement à éviter bon nombre d’écueils SEO et d’apparaître plus souvent en résultat.

Comment fonctionnent les algorithmes des moteurs de recherche ?

Les bots des moteurs de recherche commencent par sillonner le web à la récolte de sites web à placer dans leur index. Une partie d’entre eux, appelés crawlers, sont programmés pour parcourir l’ensemble des pages constituant un domaine, afin de les analyser de fond en comble selon une somme conséquente de critères de qualité.

On peut raisonnablement classer ces critères en trois catégories :

- le contenu (structure, mots-clés, richesse des textes, vidéos et images, etc.), notamment selon les critères E-E-A-T (Expertise, Experience, Authority, Trust) ;

- la performance technique (rapidité du site, qualité graphique, mobile-friendly etc.) ;

- la notoriété (longévité, volume de trafic, backlinks, etc.)

Une fois votre site passé au peigne fin, il est prêt à être positionné dans les SERPs en fonction de l’appréciation générale ainsi calculée par les algorithmes.

Quel est le processus suivi par les algorithmes des moteurs de recherche ?

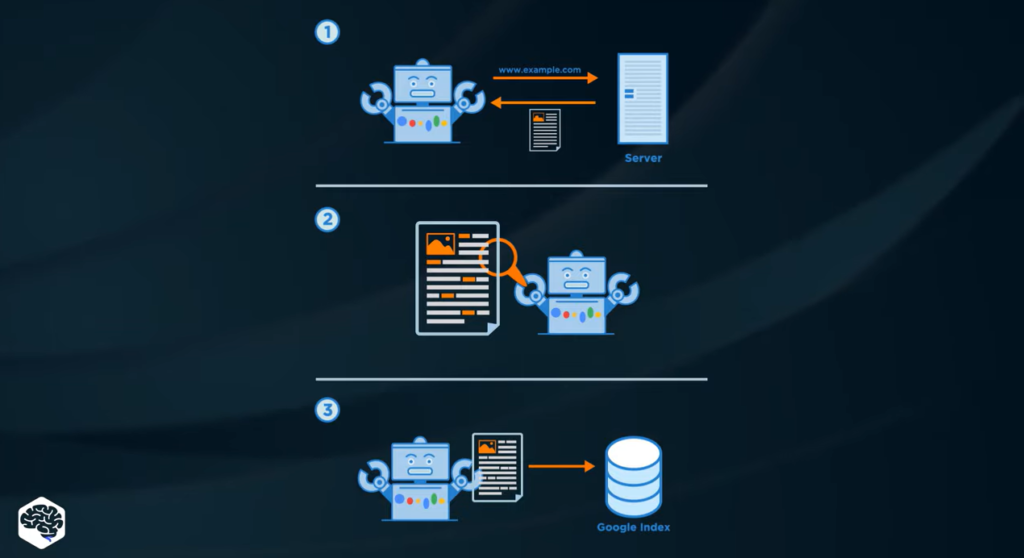

La mission d’un algorithme de moteur de recherche se scinde en trois étapes : l’exploration, l’indexation et le classement.

L’exploration (ou crawling)

C’est le rôle des crawlers, ou spiders. Comme vu un peu plus haut, ils parcourent inlassablement le world wide web en suivant les liens hypertextes qui conduisent d’une page à l’autre. Ils récupèrent les données de chaque site internet, et repassent plusieurs jours, plusieurs semaines, ou plusieurs mois plus tard.

Nota Bene : les sites que Google juge importants et utiles reçoivent plus souvent la visite des crawlers.

L’indexation

Une fois que la récolte est faite, les robots indexeurs vont se charger de ranger les URLs selon la thématique identifiée sur chacune. Cela permet de faciliter le processus de classement, car les bots n’auront qu’à choisir entre les pages d’une infime partie d’internet en se focalisant sur l’intention de recherche.

Le classement (ou ranking)

Lorsqu’un internaute saisit une requête dans la barre de recherche, les algorithmes ont pour tâche :

- l’analyse de la requête, de plus en plus fine avec les améliorations au fil du temps. Le but de l’algorithme est de répondre à la bonne intention de recherche ;

- la comparaison des termes utilisés dans la requête avec les ressources qui figurent dans l’index, afin de trouver les contenus les plus pertinents ;

- classement des URLs en fonction des critères évoqués ci-dessus ;

- affichage des SERPs avec des résultats naturels, des liens payants et des rich snippets (photos, définitions, FAQ, infographies, etc.) afin de rendre l’information rapidement accessible.

Une évolution permanente pour rester au top des moteurs de recherche

S’il y a bien quelque chose qui caractérise Google et impacte fortement le référencement naturel, c’est bien les modifications apportées très régulièrement à son algorithme. Jusqu’en 2003, le moteur de recherche renouvelait totalement son index environ une fois par mois. On appelait cela la “Google Dance” qui pouvait, au grand dam des propriétaires de domaine, redistribuer complètement le classement des SERPs.

Mais très vite, un autre phénomène a occasionné des changements drastiques de fonctionnement. En effet, les webmasters ont essayé de tirer profit du comportement encore archaïque des algorithmes, en employant des techniques qui ne tiennent pas compte de l’intérêt des utilisateurs (bourrage de mot-clé, publicités intrusives, fermes de liens, etc.).

Or, Google – mais également Bing, Baidu ou encore Yandex – cherche sans arrêt à améliorer l’expérience des internautes. Le moteur de recherche a donc dû affiner ses algorithmes afin qu’ils identifient les pratiques abusives et les sanctionnent en conséquence, du moins si elles nuisent trop à la navigation des utilisateurs.

Des centaines de mises à jour chaque année

On ne compte plus les mises à jour qui ont causé les déclassements de sites auparavant très bien positionnés. Aujourd’hui, néanmoins, les hécatombes sont plus rares malgré les mises à jour encore très fréquentes des équipes de Google, lesquelles se concentrent désormais davantage sur des détails avec une influence subtile sur le ranking.

Des acteurs SEO tels que Moz estiment à environ 500 le nombre de mises à jour algorithmiques réalisées par Google chaque année, sans pour autant le communiquer publiquement. Alors qu’entre 2 000 et 2 008, il n’en a eu que 25 !

Quels sont les algorithmes de Google à connaître ?

L’algorithme qu’on ne manque jamais de mentionner en parlant de Google est le fameux PageRank, dédié à l’évaluation de la qualité d’une page web. Il attribue une note allant de 1 à 10 (plus c’est élevé, mieux c’est) à tous les domaines indexés. C’est donc un outil essentiel pour déterminer le classement qui s’affichera dans les SERPs, mais les variables en jeu dans son calcul sont tenues secrètes afin d’éviter les tentatives de contournement.

On peut malgré tout se faire une idée des prérogatives qui font scorer au PageRank juste en observant les mises à jour majeures du moteur de recherche, lesquelles sont notamment passées par des filtres algorithmiques. Il s’agit de bots spécialisés dans un critère précis, et qui n’hésitent pas à tirer un site vers le bas des pages de résultat si les signaux obtenus pendant le crawl ne correspondent pas aux exigences de qualité instaurées par Google.

Voici donc, classés par catégories, les filtres algorithmiques à connaître quand on fait du SEO.

Pour rester à la pointe de l’actualité : Google Caffeine

Une première chose à laquelle il s’agit de s’intéresser en référencement, c’est l’indexation des pages publiées sur internet par les moteurs de recherche. Durant l’été 2010, Caffeine faisait son apparition pour accélérer considérablement le système d’indexation. Ainsi, les internautes ont eu accès à du contenu bien plus récent.

Quelques mois plus tard, l’algorithme faisait l’objet d’améliorations pour augmenter encore la fraîcheur des résultats tout en mettant en valeur les contenus plus anciens qui pouvaient demeurer plus pertinents.

Pour des résultats plus pertinents : éviter les pubs, les spams, les faux liens, etc.

Il a fallu également faire le ménage en ce qui concernait la pertinence des résultats proposés par Google. Autrement dit, comment faire pour que le contenu suggéré colle bien à l’intention de recherche des internautes ? Pour cela, au moins quatre filtres ont vu le jour :

- Google EMD (Exact Match Domain), déployé en 2012 qui pénalise les noms de domaines qui utilisent des mots-clés stratégiques sans tout à fait correspondre au contenu réel du site ;

- Top Heavy (2012) qui déclasse les sites surchargés de publicités (environ 1% des domaines à l’époque). En 2017, une mise à jour ciblera les pubs interstitielles et pop-up fréquents car jugés trop intrusifs ;

- Pingouin (avril 2012) qui traque principalement les mauvais backlinks ;

- Payday Loan (2013) qui supprime tout bonnement les résultats de type spam (contenu pour adulte, sites de jeux en ligne, etc.) ;

Aujourd’hui, les publicités doivent donc être modérées, et seuls les liens hypertextes qui favorisent l’intérêt des internautes ont un impact positif sur le référencement.

Pour un contenu de bonne qualité : Panda, Phantom, Fred, Satellite et Medic

Bien entendu, tomber sur un contenu insatisfaisant est à l’exact opposé de ce que doit proposer un moteur de recherche. C’est pourquoi Google s’équipe de :

- Panda (février 2011) qui pénalise les sites de faible qualité (articles lacunaires, orthographe médiocre, contenus spammys, etc.) ;

- Phantom ou Quality (mai 2015), une mise à jour déployée sans être annoncée par Google, qui reconnaîtra ensuite publiquement l’avoir lancée dans la continuité de Panda ;

- Satellite (mai 2015), qui sanctionne les pages qui ne servent qu’au SEO avec un contenu peu recherché, à faible valeur ajoutée,. voire carrément dupliqué ;

- Fred (mars 2017), qui traque les pages à vocation uniquement monétaire, proposant un contenu faible pour mieux vendre des encarts publicitaires aux annonceurs ;

- Medic (2018), qui ciblerait principalement les pages trop éloignées du cahier des charges E-A-T, (pour Expertise, Autorité et Confiance), avec de mauvais backlinks (sites à thématique médicale, e-commerce, etc.), et en particulier les sites de type YMYL (Your Money Your Life) ;

- Site Diversity Update pour limiter les pages issues d’un même domaine et permettre aux internautes de croiser plus facilement les sources. Il est très sensible à la structure des contenus et à l’arborescence des sites ;

- Helpful Content Update (2022) pour distinguer les contenus superficiels de ceux qui répondent véritablement à un besoin. Google en a profité pour proposer des directives permettant de générer un contenu centré utilisateur.

Nota Bene : tous ces algos font désormais partie d’un même système renommé Core Update, qui estime la qualité générale d’un site web.

Pour une expérience de navigation agréable et sécurisée

Bien sûr, outre la pertinence et la qualité, il convient aussi d’éviter tout désagrément à l’internaute. Pour cela, Google se charge de rendre la navigation la plus fluide possible avec :

- Google Vitesse (2010) qui favorise les sites avec un temps de chargement très court ;

- Pirate (août 2012), chargé de lutter contre la violation de droits d’auteurs et le téléchargement illégal ;

- HTTPS (août 2014) pour sécuriser la navigation des internautes avec un protocole permettant d’éviter les attaques provenant de hackers informatiques ;

- Mobile-Friendly (avril 2015), aussi appelé Mobilegeddon, qui va bouleverser le SEO en priorisant des sites responsive, voire mobile-first.

- Google App Indexing va, quant à lui, indexer directement les applications mobiles et tablettes pour les ressortir dans les SERPs ;

- June 2019 Core Update qui met l’accent sur la vitesse de chargement, la fluidité de navigation, la pertinence thématique globale et le passage au protocole HTTPS ;

- Core Web Vitals qui vont se focaliser sur la fluidité (FID), la stabilité (CLS) et l’efficacité (LCP) de l’affichage des pages web.

Rien qu’en tenant compte de ces 4 algorithmes, vous avez quatre optimisations concrètes et de première importance à mettre en place pour votre blog ou site internet.

Pour une meilleure compréhension des intentions de recherche

Enfin, Google a creusé la question des requêtes utilisateur jusqu’à outrepasser la simple saisie de mots-clés. Plusieurs modifications ont rendu l’algorithme plus perspicace, au point d’en devenir parfois surprenant. On pense notamment à :

- Hummingbird (septembre 2013), qui parvient à saisir les liaisons sémantiques entre plusieurs termes de la requête pour mieux comprendre le besoin de l’internaute et lui proposer des résultats plus précis ;

- Pigeon (juillet 2014), qui va tenir compte des données de géolocalisation de l’appareil pour trouver des résultats situés à proximité de l’utilisateur ;

- Rankbrain (octobre 2015) qui, dans la continuité de Hummingbird, va se souvenir d’anciennes requêtes pour déduire le besoin d’un utilisateur qui a reformulé sa saisie de mots-clés. Il parvient même à prédire certaines requêtes en fonction de l’historique de navigation ;

- Opossum (2016), qui élargit le ciblage local et gère les fiches GMB (Google My Business) pour éviter les doublons et les afficher en fonction de la localisation de l’utilisateur ;

- les metadescriptions passent de 160 à 320 caractères afin de mieux orienter les utilisateurs dans leurs recherches (sans nom) ;

- Bert (2019), qui, entre autres, va interpréter les recherches vocales grâce à une connaissance approfondie du langage naturel.

Tout cela a un impact très puissant sur le SEO : les webmasters doivent désormais se rappeler que les requêtes pouvant mener à leur site web seront formulées de manière de plus en plus naturelle (questions, phrases construites, etc.), et traitées par Google selon un certain contexte (localisation, historique de navigation, etc.).

Des algorithmes… et des humains !

Avant de conclure, il convient de préciser que Google ne peut raisonnablement pas se reposer uniquement sur des algorithmes, puisque ces derniers sont par définition imparfaits, qui peinent à s’aligner sur les besoins humains. C’est la raison pour laquelle Google emploie des évaluateurs de recherche, lesquels accomplissent plus de 40 000 évaluations de contrôle de qualité des classements chaque année, en fonction des critères que nous avons évoqués en début d’article, répertoriés sur un document de près de 150 pages !

Pour finir…

Les algorithmes Google sont la garantie pour les internautes de tomber sur un contenu en adéquation avec leurs besoins. Indexation, crawling, compréhension fine des requêtes et ranking dépendent entièrement de ces robots de plus en plus intelligents.

Les référenceurs ont donc intérêt à être avisés de leur fonctionnement. Néanmoins, tout faire en fonction du bot revient à prendre le risque de subir les effets d’une modification inattendue, ou de biais algorithmiques à interroger.

Ainsi, pour prévenir toute chute SEO liée à l’évolution algorithmique de Google, il s’agit de toujours envisager le point de vue de l’utilisateur (UX) pour chaque optimisation entreprise, afin de rester, quoi qu’il arrive, alignés avec les exigences de pertinence croissantes des outils de recherche. À cet égard, des agences SEO comme Uplix sont là pour vous concocter un référencement sur mesure !

Et si vous êtes curieux quant au fonctionnement d’un algorithme, la vidéo ci-dessus de la chaîne Science Etonnante est des plus instructives !