Qu’est-ce que le Black Hat SEO ?

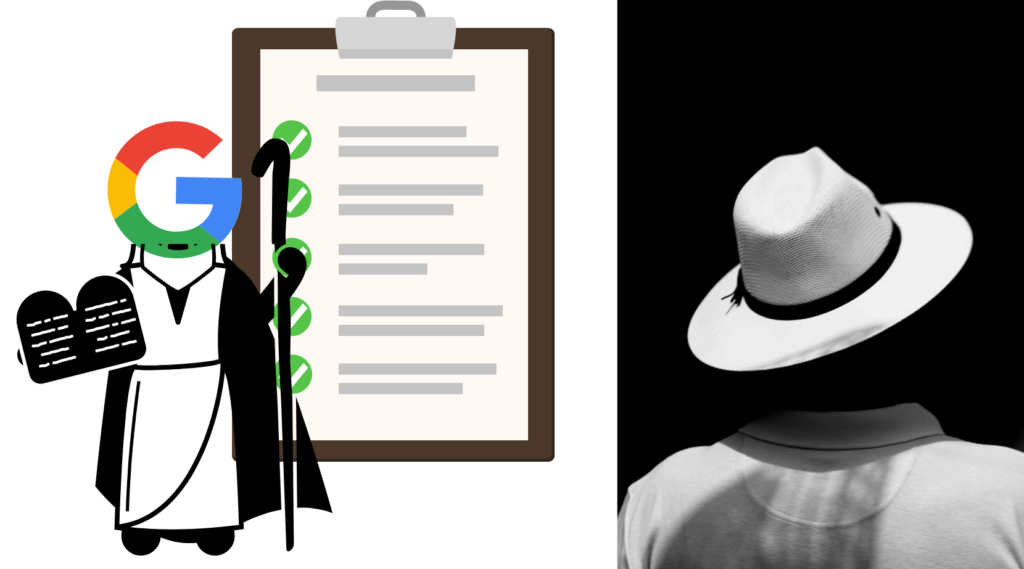

En théorie, un consultant SEO doit appliquer les « guidelines » de Google que vous pouvez lire ici. Il s’agit d’une liste de conseils permettant que de tous les sites examinés par Google en ressorte les plus légitimes qui se positionnent le mieux.

Les sites web les plus performants dans leur stratégie de marketing digital et SEO devraient donc logiquement être les mieux positionnés sur Google.

Néanmoins, comme dans beaucoup de secteurs, il existe des dérives dans le SEO. Ces dérives sont symbolisées par une pratique en particulier : le Black Hat SEO.

Cette pratique consiste en la manipulation des algorithmes de Google et des moteurs de recherche en général, dans le but d’un meilleur positionnement sur la page de résultats de recherche.

Retour sur le Black Hat SEO, les réactions de Google pour limiter cette pratique et les bons réflexes à adopter pour éviter toute pénalité.

Le Black Hat SEO : définition et cas de figure

Le Black Hat SEO regroupe tout un panel de pratiques allant directement à l’encontre des guidelines de référencement naturel dictées par les moteurs de recherche. Si l’on prend l’exemple de Google et de ses consignes aux webmasters, on remarque que l’expression de Black Hat SEO n’est volontairement pas utilisée. Toutefois, Google désigne un certain nombre de techniques à éviter pour référencer une page web, et c’est l’ensemble de ces techniques qui forme ce que l’on appelle le Black Hat SEO.

Quelques exemples de techniques dites “Black Hat”

Parmi les techniques à éviter, on peut notamment citer la génération automatique de contenu, visant à créer du texte par intelligence artificielle avec un certain nombre de mots-clés sans pour autant présenter un contenu pertinent pour l’utilisateur.

Ces méthodes peuvent amener une pénalité de Google si l’algorithme les détecte.

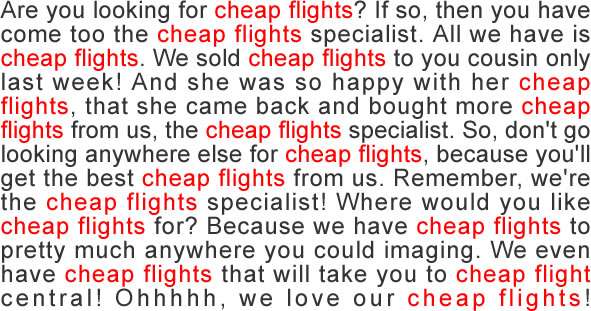

De façon similaire, le keyword stuffing concerne les sites web tentant d’améliorer leur référencement en remplissant leurs textes d’un très grand nombre de mots-clés.

On peut aussi citer la dissimulation de texte et de liens sur une page web (par exemple, en écrivant du texte blanc sur un fond blanc) : l’utilisateur ne verra pas les textes ni les liens concernés, mais l’algorithme de Google, si.

Black Hat et Netlinking

Optimiser la réputation d’un site peut s’effectuer de manière artificielle, notamment avec certaines stratégies de netlinking. En achetant des liens non contextualisés ou peu cohérents avec le site ciblé, en faisant de l’acquisition massive de liens ou encore en procédant à une stratégie de linking toxique vers le site d’un concurrent, le référenceur s’expose à mettre en danger les sites dont il est en charge.

Voici un bref récapitulatif des techniques considérées comme répréhensibles par Google :

- génération de contenu automatique ;

- netlinking agressif ou toxique ;

- keyword stuffing ;

- achat de liens non contextualisés ;

- negative SEO par duplicate content ;

- certaines formes de cloaking ;

- hotlinking, méthode consistant à afficher sur un site web une image provenant d’un autre site web, souvent sans l’accord de ce dernier ;

- Etc.

Quand le Black Hat SEO est-il utilisé ?

Le cas de figure le plus répandu est le gain rapide de positionnement sur la page de résultats de recherche. Paradoxalement, les positions visées sont alors plutôt celles du milieu de la première page de résultats. De la sorte, les sites en question sont moins facilement repérables par Google.

D’une façon plus radicale, certains sites web en fin de vie, qui n’ont donc plus rien à perdre, vont plus loin. Ces derniers vont tenter les pires techniques pour se positionner le plus haut possible sur la page de résultats de recherche, et ce, dans une optique de collection massive de données.

Cela étant, une telle stratégie est de moins en moins utilisé de manière frontale : les agences SEO proposant ces services à leurs clients ont bien compris que Google punirait à l’avenir toutes les techniques non conventionnelles. Afin de ne pas mettre en danger les sites de clients en gestion, il est bien souvent nécessaire de se tourner vers des méthodes de White Hat SEO.

Grey Hat SEO et White Hat SEO

Tous les moteurs de recherche, dont Google, incitent donc au maximum à éviter ce genre de techniques. À l’instar du hacking, les référenceurs doivent prôner un modèle plus vertueux : le White Hat SEO.

On parle de White Hat SEO lorsque l’optimisation des sites et pages web est effectuée de manière éthique, sans essayer de tronquer les algorithmes ou de jouer avec les règles.

Le Grey Hat SEO est, quant à lui, un mix de Black Hat et White Hat Seo, jouant souvent avec les limites de ce qui est autorisé par Google ou profitant des zones d’ombre sur certains sujets comme l’utilisation du content spinning parfois toléré par Google.

Le CTR est-il un facteur de ranking ?

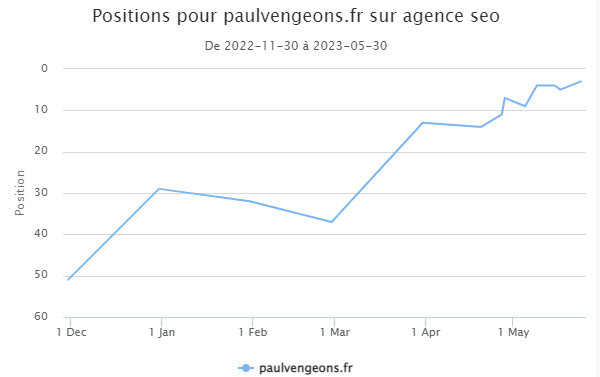

On peut parler de la manipulation de CTR avec Paul Vengeons consultant SEO qui démontre le poids ce facteur de ranking avec la requête « agence SEO » :

Belle démo d’un hack qui fonctionne !

La réponse de Google au Black Hat SEO : les pénalités

Afin d’endiguer ce phénomène, Google ne manque pas de réagir et de sanctionner les pratiques dissidentes. Si le ton adopté dans les consignes du moteur de recherche aux webmasters n’est pas celui de la réprimande, Google a tout de même instauré un système de pénalités (à voir dans notre article pour éviter les pénalités Google!) de manière à limiter le référencement abusif.

Par le biais de son algorithme ou bien par une intervention directe, Google peut décider de dégrader le positionnement d’un site sur la page de résultats de recherche. Si le référencement d’un site est considéré par le moteur de recherche comme non conforme à ces règles, on peut s’attendre à ce qu’il subisse cette pénalité.

Dans les situations extrêmes, et notamment en cas de récidive, Google se réserve le droit de désindexer les sites web en question s’ils ne se conforment pas aux règles. De ce fait, ils n’apparaîtront plus du tout dans les pages de résultats des utilisateurs lors d’une recherche.

Le moins que l’on puisse dire est que Google ne lésine pas sur ses efforts dans sa lutte contre les pratiques abusives. Google tient en effet à jour quotidiennement une liste de sites malicieux, où environ 10 000 nouvelles URLs sont répertoriées chaque jour. Toutefois, tous ces sites ne sont pas uniquement signalés pour des pratiques abusives. S’il est difficile de quantifier le phénomène, on juge à 15% environ la proportion de sites web ayant recours à des techniques de Black Hat SEO dans les dix premières pages de résultats de recherche.

Vos questions, nos réponses !

Pourquoi éviter le Black Hat SEO ?

Avoir recours à des techniques déconseillées peut donc conduire votre site web à voir son positionnement baisser drastiquement et peut même mener à la suppression du référencement de votre contenu.

Outre ces conséquences, les techniques abusives de référencement ne sont pas pérennes : si l’on peut réussir à fausser son référencement un temps, il est impossible de tenir sur le long terme sans une stratégie de marketing digital éthique. En effet, certaines techniques douteuses non réprimandées par Google le seront sans aucun doute à l’avenir et les différentes mises à jour de Google l’ont bien montré.

Mais plus encore, ce genre de technique a tendance à s’appliquer au détriment de l’expérience utilisateur. Là encore, il est difficile de faire perdurer une telle stratégie qui, à terme, nuit au taux de conversion d’un site web.

Comment ne pas tomber dans le piège d’une stratégie de Black Hat SEO ?

Le plus difficile dans les mauvaises techniques de référencement, c’est de les reconnaître ! En effet, beaucoup d’entreprises utilisent des méthodes douteuses sans même le savoir ! De manière à éviter de mauvaises surprises, n’hésitez pas à vous informer régulièrement sur les mises à jour de l’algorithme de Google. Vous pourrez ainsi vérifier si votre contenu est bien en conformité avec la réglementation en vigueur.

Si vous avez recours à des prestataires externes pour votre SEO, vous devrez, là aussi, vous assurer de leurs bonnes pratiques. Par exemple, une agence de SEO vous promettant un rang donné sur Google et un trafic garanti, le tout sans être totalement transparente, peut parfois avoir recours à des techniques peu recommandables. Cela peut se révéler extrêmement dommageable à long terme pour la réputation de votre site.

Pour un SEO “propre”, n’hésitez pas à exiger la transparence !