Mis à jour le 31/03/2025

La désindexation est le terme couramment employé pour désigner le fait de supprimer une page web de l’index des moteurs de recherche tels que Google ou Bing. En conséquence, l’URL n’apparaîtra plus dans les SERPs, mais pourra toujours être consulté par une personne disposant de l’adresse exacte, s’il la saisit dans la barre de son navigateur (Chrome, Firefox, etc.).

Cela réduit invariablement la visibilité de la page en question, et par extension le trafic organique du site web tout entier.

Dans cet article, nous allons voir en quoi la désindexation est autant un problème à éviter qu’un levier SEO stratégique à utiliser dans des certains cas bien précis !

La désindexation côté moteur de recherche : pas glop…

Quand c’est le moteur de recherche qui prend l’initiative de désindexer des pages web, c’est généralement mauvais signe. En effet, il se peut que l’ensemble du site soit touché, et pas uniquement quelques pages inutiles.

La problématique survient généralement dans les cas suivants :

- un abus du fonctionnement des moteurs de recherche. En effet, beaucoup de webmaster ont déjà cherché à exploiter des failles de Google et consort pour ranker plus vite. On appelle cela le black hat SEO ;

- un problème technique qui freine les crawlers au moment d’explorer et de recenser les pages d’un site web ;

- un contenu obsolète ou simplement éloigné de toute espèce de pertinence…

Si vous n’avez pas vous-même engagé un processus de désindexation ponctuel, il convient de veiller régulièrement à ce que vos pages soient bien indexées et toujours à jour sur le moteur de recherche !

Quels sont les éléments à surveiller pour expliquer une désindexation indésirable ?

Si vous constatez qu’une de vos pages a été désindexée sans intervention de votre part, posez-vous des questions sur les points suivants…

La qualité du contenu proposé

Le maître mot des moteurs de recherche est sans aucun doute “pertinence”. Pour draguer un moteur de recherche, il faut donc commencer par proposer des ressources fiables, utiles et si possibles de meilleure qualité que les autres sources d’information disponibles sur un même sujet.

En effet, Google a mis en place des algorithmes pour veiller à ne pas suggérer tout et n’importe quoi aux internautes. Un des plus connus reste Panda, un filtre conçu pour lutter contre la prolifération de contenus sans valeur, et publiés uniquement pour attirer du trafic et obtenir des revenus grâce à la publicité digitale.

Attention donc avec tout ce qui est contenu spammy ou généré automatiquement, qui peuvent s’avérer hautement médiocres ! C’est notamment le cas avec le content spinning, à savoir le fait de reprendre un texte original et de le décliner avec une panoplie de synonymes et quelques changements de tournure, mais dans le fond, strictement identiques.

L’optimisation des mots-clés

Avant même d’être un facteur de ranking, l’optimisation des mots-clés intervient dans le processus d’indexation. Attention toutefois à ne pas succomber à la tentation du keyword stuffing, qui consiste à surcharger vos pages de mots-clés. Un excellent moyen de subir une pénalité allant jusqu’à la désindexation !

Arborescence de site et maillage interne

Les crawlers n’ont pas le temps ! Si vous voulez utiliser convenablement votre budget crawl, faites en sorte que votre site ait une structure cohérente, qui favorise leur navigation. Le maillage interne va notamment jouer un rôle dans le processus d’exploration.

Bien sûr, avec une architecture branlante, vous ne risquez pas une désindexation proprement dite, mais simplement une absence d’indexation de pages potentiellement utiles !

La vitesse de chargement du site

Un site trop lent à charger empêche l’indexation de l’ensemble de ses pages, et a fortiori n’ira pas très loin en SEO. Veillez à ce que tout soit en ordre à ce sujet, ou vous risquez de voir vos pages très bas dans les SERPs, même si, par miracle, elles ont pu être indexées !

Bref…jouez le jeu !

Tenez une veille des bonnes pratiques SEO (white hat), faites confiance aux directives de Google pour un jour arriver au sommet des SERPs, et vous éviterez tout problème de désindexation impromptue !

Désindexation côté webmaster

On parle également de désindexation pour évoquer une pratique SEO visant à retirer soi-même de l’index des moteurs de recherche des pages pouvant compromettre le bon référencement d’un site internet.

En général, ces pages, pour une raison ou pour une autre, ne respectent pas les conseils ci-dessus, et les webmasters ou experts SEO s’en sont rendu compte (ou alors ils suivent un plan de publication précis et attendent avant de soumettre une page aux crawlers).

À quoi sert la désindexation en SEO ?

Les deux principaux avantages d’une désindexation à l’initiative d’un webmaster sont l’optimisation du budget crawl et la réduction du risque des pénalités Google.

Le budget crawl, c’est le temps et le nombre de pages maximal que les bots d’exploration Google (et autres) peuvent parcourir chaque fois qu’ils passent sur un site. Ainsi, si vous laissez les crawlers passer du temps sur des pages sans aucun intérêt SEO, c’est du budget crawl gaspillé, et des pages plus utiles potentiellement non indexées à l’arrivée.

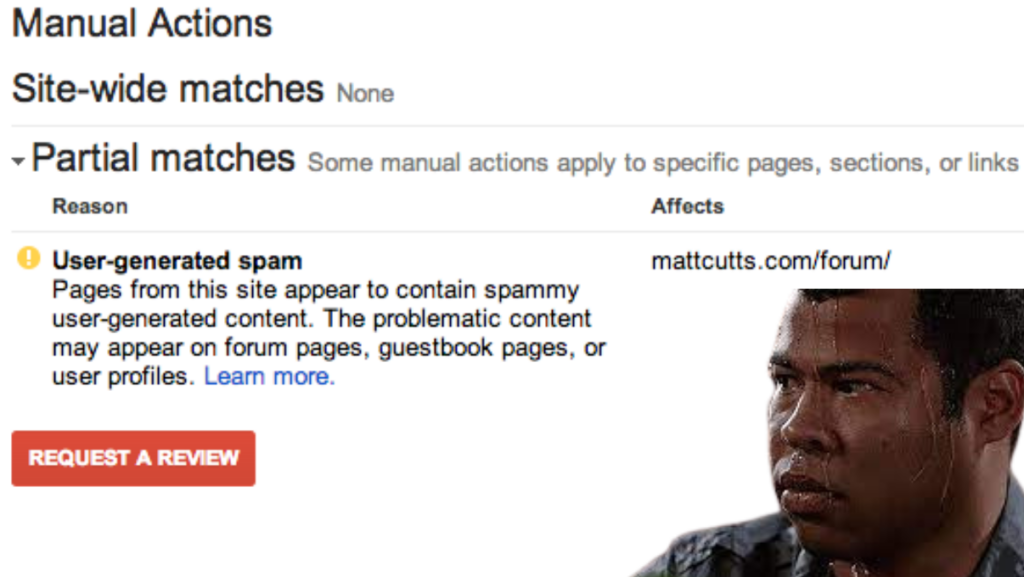

D’autre part, les pénalités Google, qu’elles soient automatiques ou manuelles, surviennent lorsqu’un site présente des contenus de mauvaise qualité ou des caractéristiques suspectes, pouvant laisser croire à l’utilisation de techniques black hat. Or, si une page subit une pénalité, c’est possiblement tout le site qui en subit les frais.

Quels sont les cas courants de désindexation stratégique ?

Voici une liste pour vous faire une idée des pages qu’on va avoir envie de désindexer au profit de son référencement :

- les contenus éphémères et obsolètes qui ne génèrent plus de trafic ;

- les URLs de fichiers PDF dont le contenu existe déjà en HTML sur un blog ou autre ;

- les pages de résultats internes pour les gros sites qui intègrent un moteur de recherche

- les pages avec du duplicate content ;

- les pages avec formulaires, qui ne sont guère des contenus considérés comme “pertinents” par les moteurs de recherche ;

- les pages contenant des informations confidentielles (qui donc ne doivent pas circuler librement sur des pages de résultats de recherche !)

Dans tous les cas, posez-vous les questions suivantes :

- à quel besoin réel des internautes le contenu de ma page répond-il ?

- le contenu produit fait-il sens avec mon activité ?

- quelle est la valeur stratégique de ma page en matière de référencement ?

Comment désindexer soi-même les pages de son propre site web ?

D’abord, il s’agit de ne pas confondre la désindexation et le simple blocage des crawlers. En effet, la désindexation d’une page revient à dire qu’on la retire de l’index : elle y figurait donc déjà. Tandis que le blocage des robots d’exploration signifie qu’on les empêche de parcourir et d’analyser une zone plus ou moins étendue d’un domaine.

Cette distinction va permettre d’éviter des erreurs telles que la combinaison contradictoire de deux instructions, à savoir ne pas explorer et désindexer. Si une page est déjà dans l’index d’un moteur de recherche et que les bots sont incités à l’ignorer au moment de visiter votre site, ils ne pourront pas suivre l’appel à la désindexation…

Bref, ce serait comme demander à quelqu’un de respecter la règle d’un jeu sur un manuel qu’il n’aurait pas le droit de lire… Maintenant que vous savez faire la différence, voici plusieurs techniques pour désindexer ce que vous voulez quand vous voulez :

- avoir un sitemap dédié à la désindexation, que vous soumettrez à la Search Console comme un sitemap normal. Vous pouvez également demander la suppression d’une seule ou quelques URLs isolément ;

- passer par le fichier robots.txt, soit pour la commande disallow (ne pas parcourir une partie du domaine), soit pour la directive noindex (désindexation des pages concernées) ;

- utiliser la balise meta robots, située dans l’en-tête d’une page, et qui peut également prendre en charge la directive noindex ;

- se servir de la balise X-robots-tag dans le fichier .htaccess, en particulier pour les contenus au format différent de HTML (PDF, Word, Excel, images etc.) ;

- placer un code 410 pour supprimer des contenus totalement obsolète et désormais ignoré des internautes (donc pas de trafic et/ou peu de backlinks) ;

- utiliser une redirection 301 pour les contenus obsolètes avec une forte valeur SEO (haut trafic et plein de link juice). Les internautes atterriront sur une nouvelle URL sans s’en rendre compte, et l’ancienne finira par sortir de l’index Google.

Pour finir…

La désindexation doit rester une manipulation venant du webmaster. La technique employée va souvent dépendre de la raison qui le pousse à faire retirer une page de l’index des moteurs de recherche.

À l’inverse, une désindexation involontaire doit absolument vous pousser à corriger des défaillances techniques ou sémantiques toxiques pour votre référencement.

N’hésitez pas à passer par une agence SEO si vous soupçonnez l’application d’une pénalité, afin de comprendre au plus vite ou se trouve votre erreur !