Mis à jour le 01/04/2025

Les algorithmes de Google sont programmés dans le cadre de mises à jour, afin que le célèbre moteur de recherche soit en mesure d’affiner la pertinence des suggestions qu’il fait remonter dans ses pages de résultats. Il en existe un certain nombre, comme Panda, Fred, Bert ou Hummingbird, révélés au grand public dans le but d’inciter les webmasters à adopter des stratégies gravitant davantage autour du spectre White Hat que celui du Black Hat.

Penguin (ou “Pingouin”, par abus de langage, puisque l’on devrait normalement traduire par “manchot”), existe pour certifier l’authenticité des signes de notoriété émis par un site internet. Autrement dit, il surveille la nature des backlinks obtenus. Sont-ils artificiels ? Suroptimisés ? Spammys ?

Dans cet article, Uplix vous propose d’examiner les raisons du déploiement de Google Penguin, son fonctionnement actuel et la meilleure façon de développer votre netlinking sans avoir affaire à son courroux automatique !

Pourquoi Google a-t-il créé l’algorithme Pingouin ?

Avec plusieurs centaines de milliards de sites indexés, Google doit relever deux défis de taille : sélectionner les meilleures ressources, notamment à l’aide d’une correspondance entre les mots-clés d’une saisie de recherche et le contenu de chaque page, et se prémunir contre les innombrables tentatives de manipulation de la part des webmasters qui induisent Googlebot en erreur.

Avec les années, le premier problème a été partiellement solutionné par la réputation des sites internet : les plus fréquentés et les plus recommandés, notamment au moyen de backlinks, attirent plus facilement la confiance des bots. En effet, ce comportement de la part des internautes témoigne de leur satisfaction collective : il n’y a qu’à suivre le courant.

Les propriétaires de sites web s’en sont rendu compte, ce qui a aggravé le second problème. Ainsi, parmi les techniques pour abuser des mécanismes des crawlers, sont apparues celles qui jouaient sur l’acquisition de liens entrants. Si obtenir de nombreux backlinks était gage de popularité, et donc de pertinence dans la méthode d’évaluation encore rudimentaire des bots, pourquoi ne pas en fabriquer au lieu d’attendre de les recevoir ?

La conséquence néfaste de ce raisonnement a été un abaissement général de l’expérience de navigation, non seulement à cause d’un ranking perturbé, mais également à cause des liens eux-mêmes, qui conduisaient les internautes et les bots d’indexation sur des pages non-pertinentes.

Des filtres algorithmiques pour arbitrer les ressources grandissantes d’internet

Pour remettre de l’ordre dans les SERPs, il était capital de détecter rapidement les pages de mauvaise qualité, mais aussi celles qui se faisaient passer pour populaires, et de sévèrement les déclasser, voire les désindexer. Difficile de mettre uniquement une équipe d’humains sur le coup : il fallait agir à grande échelle et mobiliser de nouveaux algorithmes, en mesure à la fois de juger et de sanctionner de manière autonome les sites profitant de pratiques non éthiques.

Une vague s’est alors abattue dans le monde du référencement, car les missions de Pingouin allaient viser et surprendre un sacré paquet de monde…

Comment fonctionne Google Pingouin ?

Mis en place le 24 avril 2012, Google Penguin évoluera jusqu’en 2016, passant par au moins 7 mises à jour. Pendant cette période, les sites défavorablement impactés doivent remanier d’urgence leur netlinking et attendre la prochaine version de l’algorithme pour espérer revenir à leur classement normal, ce qui pouvait prendre jusqu’à une année complète !

Le 23 septembre 2016 sort Penguin 4.0, qui va désormais se mettre à jour en continu, et ainsi permettre aux sites pénalisés de revenir plus rapidement dans la course SEO. Dans les grandes lignes, le voilà désormais capable d’intervenir contre :

- les backlinks de faible qualité, issus de mauvais sites de communiqués de presse, de contenus sans intérêt, de commentaires spammys sur des plateformes tierces, ou principalement rédigés dans une autre langue ;

- les backlinks artificiels, qu’ils soient achetés, échangés entre plusieurs sites, qu’ils proviennent de linkfarms ou encore de domaines identifiés comme appartenant au même propriétaire, dans une logique de linkweel ;

- les liens malveillants, avec des redirections trompeuses et des tentatives de phishing ;

- les ancres de lien suroptimisées avec trop de mots-clés, et répétées sur plusieurs backlinks ;

- le keyword stuffing (ou “bourrage de mots-clés”) dans les balises (titres, metadescription, URL) et le contenu qui reçoit le lien ;

Nota Bene : il semble que les liens depuis les annuaires soient moins touchés, même si leur degré d’autorité reste un critère de pénalisation ou non. Les campagnes de référencement massif sur plusieurs milliers de pages d’annuaires de faible notoriété aboutiront sans nul doute à des sanctions.

Google Penguin : quelles conséquences dans le monde du SEO ?

Avec ce nouveau paramètre en jeu, entre 3 et 5% des requêtes ont été impactées rien qu’en anglais, dès la première version de Penguin. Les propriétaires de domaine doivent désormais rester très attentifs à :

- d’éventuelles pertes de position dans les SERPs, sans notification dans la Search Console, contrairement aux pénalités manuelles ;

- une désindexation partielle ou totale du site concerné, suite à une diminution, voire à une suspension du budget de crawl de la part de Googlebot ;

- un blacklistage pur et simple, ce qui correspond plus ou moins à une désindexation nette et définitive de l’ensemble du site web.

Autant dire que dès le premier niveau de sanction, la perte de capitaux est déjà relativement embarrassante, surtout lorsque l’on a acheté des liens trop chers. Il a donc fallu renverser la vapeur d’urgence et se débarrasser d’un maximum de backlinks factices.

La réaction la plus vertueuse (ou du moins espérée par les équipes de Google) a été la promotion du linkbaiting, consistant à tenter d’acquérir naturellement des liens en misant avant tout sur la qualité d’un site et de son contenu, en vue d’acquérir un avantage durable dans les SERPs, même si cela requiert davantage de temps. Au fil du temps, il est devenu difficile de se passer de cette étape au sein d’une stratégie de référencement naturel.

Nota Bene : ce n’est pas pour autant que toutes les techniques estampillées Black Hat (ou Grey Hat, le cas échéant) ont totalement disparu. Elles sont simplement plus subtiles, moins agressives, afin de ne pas dépasser une certaine limite, laquelle demeure assez floue, par ailleurs.

Quelles pratiques sont tolérées par Google Penguin ?

Pour être tranquille, il vous faut des backlinks :

- provenant de sites vraiment qualitatifs, avec un PageRank élevé ;

- depuis des pages dont la thématique est proche ;

- issus de domaines qui ne vous appartiennent pas ;

- depuis des sites de différentes natures (e-boutique, blogs, annuaires, sites vitrines, forums, etc.) ;

- placés dans un contenu avec une ancre utile à l’utilisateur ;

- acquis sur une durée raisonnable ;

L’algorithme se sert de ces critères notamment pour estimer les chances qu’un lien soit naturel ou non. Pour une approche totalement White Hat, il convient de se mettre au linkbaiting, grâce à des contenus à forte valeur ajoutée, mais également des produits et des services attractifs. En ce sens, la santé même de votre entreprise, bien au-delà de sa représentation numérique et du SEO qui la soutient, joue un rôle majeur dans la réussite de votre netlinking.

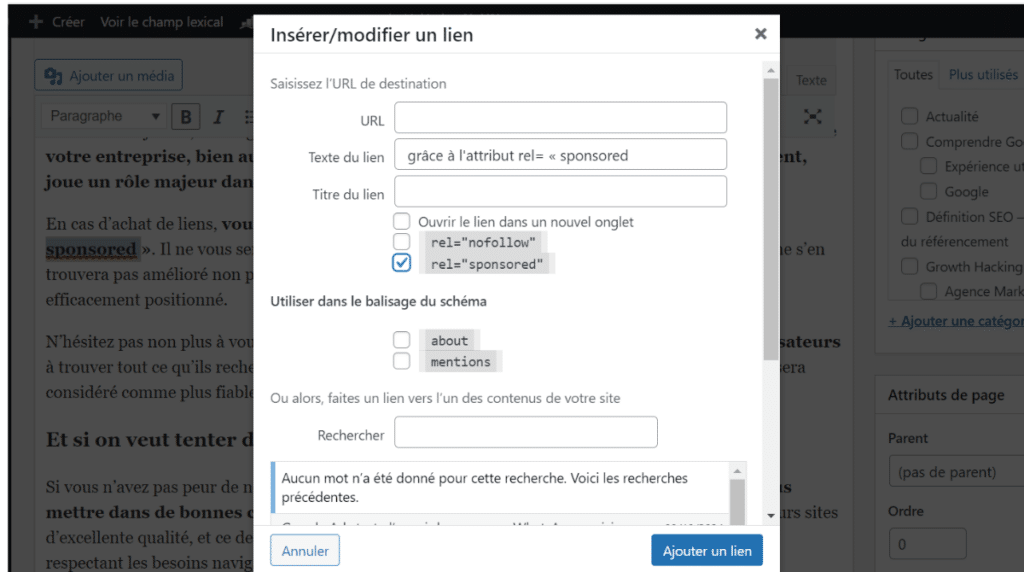

En cas d’achat de liens, vous pouvez le signaler de vous-même grâce à l’attribut rel= « sponsored ». Il ne vous sera pas reproché d’avoir acheté votre backlink, mais votre profil de lien ne s’en trouvera pas amélioré non plus. En revanche, vous augmenterez votre volume de trafic si le lien est efficacement positionné.

N’hésitez pas non plus à vous-même distribuer quelques liens sortants qui aident vos utilisateurs à trouver tout ce qu’ils recherchent, même en dofollow. Même si cela libère du linkjuice, votre site sera considéré comme plus fiable.

Et si on veut tenter de faire du Grey Hat ?

Si vous n’avez pas peur de noircir un peu le chapeau, quelques échanges de liens peuvent vous mettre dans de bonnes conditions pour la suite. Mieux vaut néanmoins le faire entre plusieurs sites d’excellente qualité, et ce de manière épisodique. D’ailleurs, rien ne vous empêche de procéder en respectant les besoins navigationnels des internautes, avec :

- des ancres diversifiées et optimisées sans exagération ;

- peu d’autres liens sur la page ;

- une raison pertinente de le placer, avec une valeur ajoutée au bout ;

Certes, vos backlinks resteront artificiels mais vertueux. Sans répercussions négatives sur l’utilisateur, ils ne pousseront pas Penguin à réagir.

Que faire en cas de pénalité Penguin ?

D’abord, il faut s’en rendre compte, puisque les filtres algorithmiques ne prennent pas la peine de vous avertir quand ils déclassent votre site web. C’est pourquoi il convient de guetter les baisses de trafic anormales et l’évolution du classement moyen de vos pages sur Google Analytics. Si vous constatez un problème inexplicable, vous pourrez alors explorer la piste de la pénalité Penguin.

Analyse de vos backlinks

Après la lecture de cet article, vous savez pertinemment ce qui peut vous compromettre dans votre stratégie de netlinking. Mais outre les pratiques risquées que vous auriez pu employer, vous pouvez aussi recevoir de mauvais backlinks à cause :

- d’une attaque de negative SEO ;

- d’un rachat de nom de domaine sans l’avoir bien audité.

Dans les deux cas, vous êtes bon pour un audit complet de vos backlinks via la Search Console de Google ou n’importe quel outil SEO sérieux comme SEMrush ou Ahrefs. Si vous ne constatez rien d’inhabituel, l’explication est probablement ailleurs.

Nota Bene : par mesure de précaution, n’hésitez pas à vérifier l’indexation de vos pages, en tapant sur la barre de recherche Google “site:www.nomdevotresite.com”, et sur la Search Console.

Recommandations générales en cas de pénalité Penguin avérée

Tout d’abord, pas de panique ! Tant que votre site n’est pas désindexé, les dégâts restent gérables. La première réaction importante va être de trier, de modifier ou de supprimer les liens qui vous tirent vers le bas. En fonction de leur origine, vous n’aurez en général qu’une option parmi les trois suivantes :

- procéder manuellement en on-site si vous avez accès à la page d’où provient le backlink véreux. Changez vos ancres, modifiez les mots-clés associés, etc. Cessez également la publication massive de communiqués de presse en ligne, le cas échéant ;

- contacter le propriétaire du domaine pour lui demander d’agir. Essayez de conserver le lien s’il peut être replacé de façon avantageuse pour vous. Sinon, demandez sa suppression pure et simple. S’il s’agit d’un de vos partenaires, vous devriez facilement trouver un terrain d’entente ;

- désavouer le ou les backlinks nocifs si, et seulement si, vous êtes confronté à un inconnu qui fait la sourde oreille devant votre requête.

L’outil de désaveu est directement intégré à la Google Search Console, mais il est vivement recommandé de ne pas en abuser. À ce titre, assurez-vous que les liens concernés sont bel et bien de nature à plomber votre site.

Après avoir fait le ménage, patientez en gardant un œil sur vos courbes de trafic. Si rien n’a bougé après deux semaines, il est grand temps de faire appel à une agence telle qu’Uplix afin de débusquer l’erreur sans perdre davantage de temps et de nerfs !

Pour finir…

Tous les référenceurs se souviennent de l’introduction de Google Penguin et des chamboulements stratégiques qu’il a induit en moins d’une décennie. Bien sûr, il était rageant de ne plus pouvoir hacker aussi facilement le système de classement des premiers Googlebots.

Toutefois, le challenge consistant à intégrer l’expérience utilisateur au sein d’une stratégie SEO a rendu la tâche des consultants à la fois plus intuitive et plus complexe. En effet, au lieu de créer des usines à liens factices, il a fallu passer au sur-mesure, et c’est ce qui rend ce secteur passionnant !