L’optimisation d’un site internet pour un meilleur référencement est un travail ardu, et les choses ne vont pas en s’arrangeant ! Malgré une prédominance du SEA dans les budgets d’entreprise, de plus en plus de propriétaires de serveurs se tiennent au fait des problématiques SEO.

En conséquence, la concurrence se fait rude..

Dans le même temps, les moteurs de recherche, et a fortiori Google (qui n’est pas dominant dans tous les pays…), perfectionnent leurs algorithmes afin de valoriser les pages vraiment pertinentes pour chaque requête. Il en ressort souvent que la qualité du contenu et de l’expérience utilisateur gagne en importance. Mais année après année, il semble que la précision soit davantage de rigueur en manipulation SEO.

Et l’empirisme des tâtonnements devient synonyme de perte de temps pour ranker votre site web. C’est pourquoi Uplix travaille sur un système de machine learning dédié au Predictive Rankings. Présentation d’une IA à venir prochainement…

Où en est le SEO en 2021 ?

Connaissez-vous les échecs ? Lorsqu’on y joue, on dit qu’un coup doit “améliorer notre position”. C’est exactement la même chose pour un site internet dont on va modifier une page, tant dans son contenu que dans son aspect technique.

Or, aux échecs, si, avec quelques principes de bases, on parvient aisément à faire quelques beaux progrès, ça se corse rapidement dès lors que l’on cherche une véritable maîtrise du jeu. Idem en SEO : 90% du temps, quelques bonnes pratiques suffisent à vous faire monter dans les SERP.

Mais lorsque la concurrence se fait rude, tous les facteurs de ranking peuvent gagner en importance. Car, comme aux échecs, le moindre petit avantage à haut niveau peut vous assurer la victoire !

Aux échecs, les GMI ont donc des “prépas cahier”, c’est-à-dire des lignes de parties étudiées de fond en comble. Aujourd’hui, de puissantes IA telles que Stockfish et AlphaZero les aident à peaufiner leur préparation.

Quant à nous, nous développons notre propre outil de machine learning, afin de prédire, non les meilleurs coups d’échecs, mais les meilleurs leviers pour obtenir une excellente position dans les pages de résultats.

D’où la dénomination de Predictive Rankings ! Dans l’attente de sa sortie, baptisons-le ULI (Uplix Lab IA).

Comment prioriser les recommandations qui ont le plus de potentiel grâce au Predictive Rankings ?

Comme évoqué un peu plus haut, la bonne nouvelle, avec le SEO, c’est qu’on connaît les leviers qui vous pousseront à coup sûr un peu plus haut sur les pages de résultats Google. Autrement dit, si vous les négligez, vous êtes presque certain.e de sous-performer.

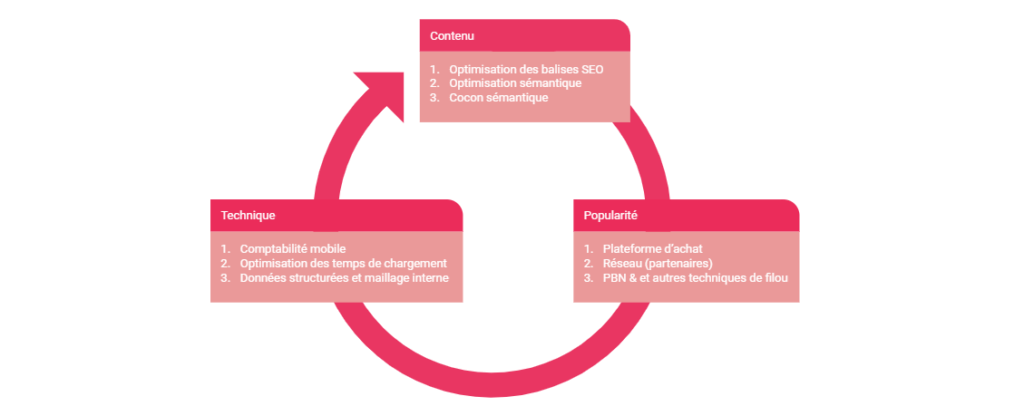

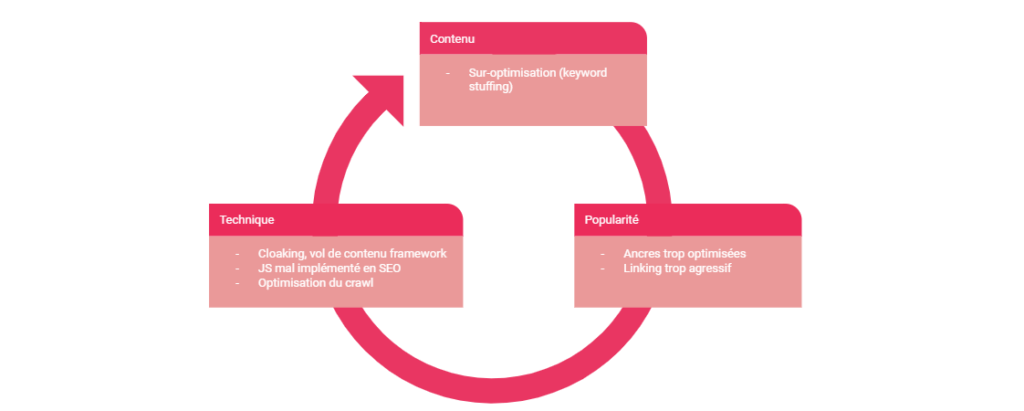

En règle générale, on peut classer ces critères – non seulement importants mais juste essentiels – en trois catégories-piliers : le contenu, la technique et la popularité. En eux-mêmes, ces piliers impliquent des dizaines d’éléments.

Cependant, il en existe à prioriser absolument ; un peu comme une constante stratégique. Aux échecs, par exemple, on dit qu’il faut développer ses pièces, attaquer au centre du plateau et mettre son roi à l’abri.

Dans le cadre du SEO, voici donc les bases les plus importantes selon moi :

Pour la partie contenu SEO d’une page web

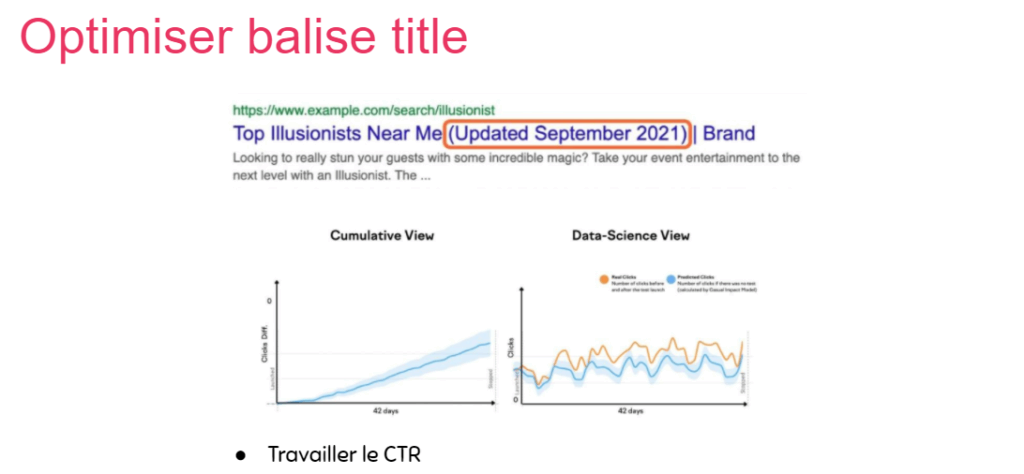

Optimiser les balises SEO (titles, metatitle, dates et updates dans les snippets, etc.). Il s’agit, par exemple, de mettre les gros mots-clés sur les titres de vos parties et sous-partie ;

- Optimisation sémantique : on modifie le contenu grâce à un outil comme SEOquantum pour faire apparaître ou disparaître des mots-clés sans modifier le sens de la publication. Une manière d’être plus explicite aux yeux de Google ;

- Tisser un cocon sémantique : traiter de sujets thématiquement très proches afin d’apporter comme une densité sémantique avec divers articles fortement liés les uns aux autres. Google vous considère alors plus facilement comme un spécialiste de votre domaine.

Exemple instructif de cocon sémantique : Maisonae

En traitant de sujets très liés les uns aux autres, on crée une sorte de masse à la manière d’un cocon constitué de fils de soie. Si l’on prend leur arborescence autour du mot-clé “bébé”, voyez ce que l’on obtient :

Visuellement, on voit que chaque sous-catégorie est fortement en lien avec les autres. Vous le sentez, le côté satisfaisant du site à la fois complet et bien structuré autour de gros piliers ? Eh bien Google le sent aussi !

Partie Technique des arcanes du référencement

- Faire un site mobile friendly ab-so-lu-ment ! Ou bien responsive, ou bien mobile first… À ce sujet, n’hésitez pas à consulter notre article sur les sites responsives !

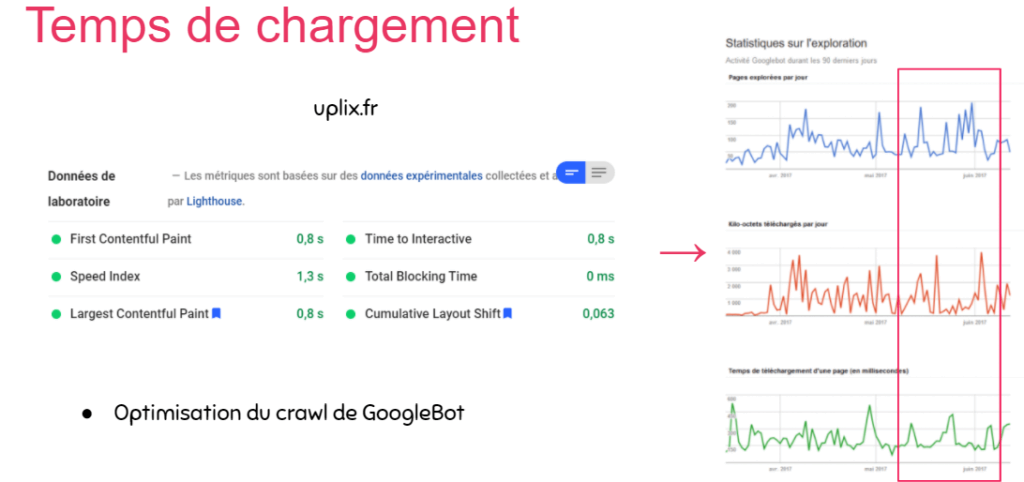

- Réduire le plus possible les temps de chargement : site long à charger = taux de rebond élevé. CQFD ! Par ailleurs, n’hésitez pas à bifurquer vers notre article sur les CDN pour en apprendre davantage ;

- Structurer ses données en matière de maillage interne : quand vous renvoyez l’utilisateur vers vos propres articles, il faut veiller à garder de la cohérence en ne vous éloignant pas trop de votre cocon sémantique. Autrement dit, ne passez pas du coq à l’âne !

Partie Popularité d’une bonne stratégie SEO

- Passer par des plateformes d’achat afin d’acquérir facilement quelques backlinks chez des sites web avec une bonne notoriété ;

- Avoir une bonne présence sur les réseaux sociaux : une forte activité booste la notoriété ;

- PBN (Private Blog Networks) avec des sites wordpress.com, blogger.com ou encore tumblr.com et autres techniques de marlou pour se faire connaître.

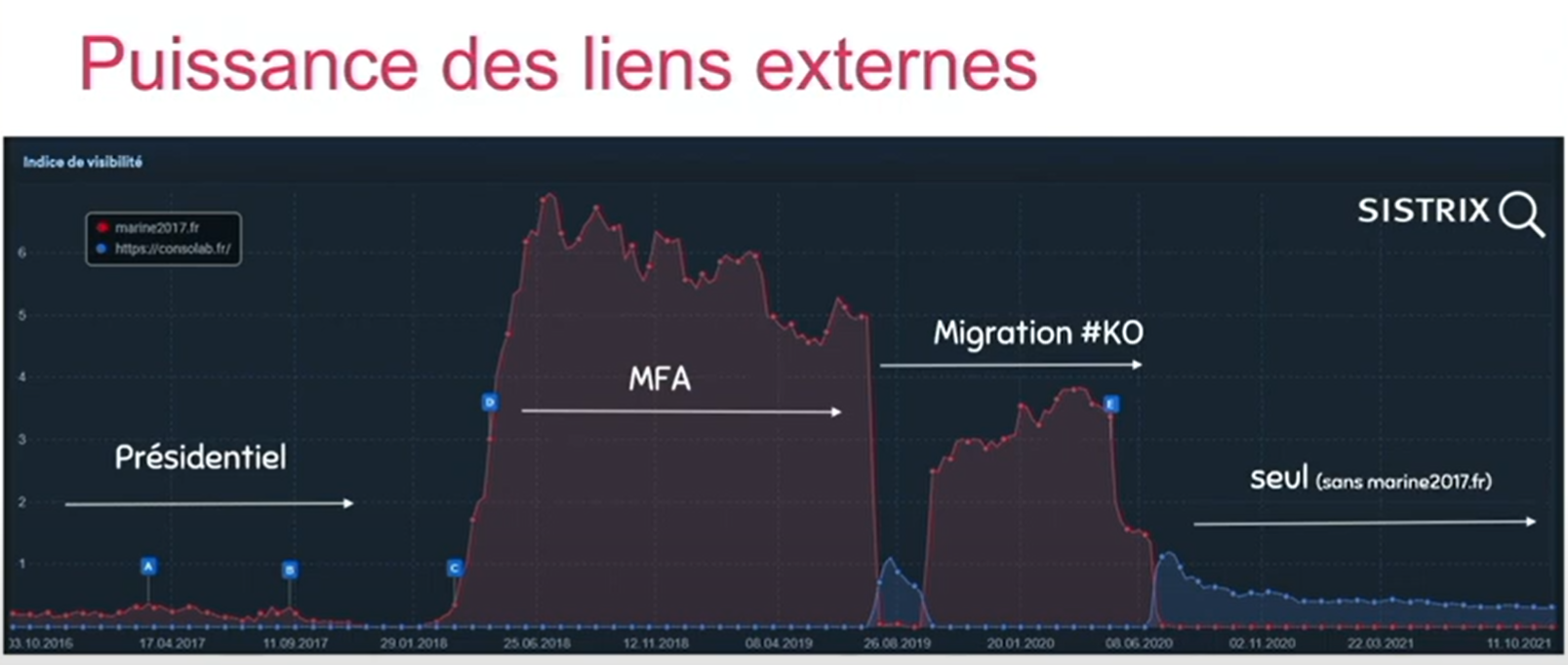

De l’importance des Backlinks : l’exemple d’un rachat de domaine très intéressant

Après les présidentielles 2017, le site de MLP a été racheté par un quidam, lequel a posté du contenu complètement sans rapports avec la politique. Mais comme le site de MLP bénéficiait, au départ, de nombreux backlinks provenant d’autres sites (avec des ancres de type “cliquez-ici”), le domaine – avec ses nouveaux contenus – s’est vu enregistrer un pic de visites assez époustouflant (aux alentours de janvier 2018).

Puis, en juin 2019, le nouveau propriétaire du site a tenté une migration et a vu son taux de visites chuter d’un seul coup ! Voilà pourquoi ce dernier s’est ravisé deux mois plus tard, de sorte à redresser la barre pour la première moitié de 2020. Cet exemple illustre bien l’impact très puissant des backlinks sur votre trafic, donc sur votre popularité, donc sur votre positionnement dans les SERP !

Vision sur-mesure d’une étude SEO (plus rare)

Bien entendu, ce n’est pas tout. Il existe probablement plus de cent facteurs de ranking. Mais très souvent, une fois qu’on a revu et optimisé ces neuf points-là, on part déjà du bon pied ! À la manière de la loi de Pareto, 20% d’efforts rapportent environ 80% des bénéfices à espérer.

En ce qui concerne les 20% de bénéfices, c’est 80% des efforts qu’il reste à fournir pour les obtenir. C’est là qu’intervient l’approche sur-mesure.

Il arrive que, lors d’un audit SEO, l’on soit amené à effectuer des corrections sur des pratiques SEO maladroites en matière de :

- Contenu : trop de mots-clés non-pertinents pour le contenu peuvent amener à des pénalités ;

- Technique : problèmes d’indexation, de crawl, de cloaking ou encore de JavaScript à vérifier sur le serveur ;

- Popularité : avec des ancres sur-optimisées ou du linking agressif (fermes de liens par exemple, vous vous attirez facilement les foudres de Google Penguin ;

Il arrive que les véritables problèmes à corriger soient plus difficiles à identifier ou à prioriser. C’est là qu’intervient ULI !

Predictive Rankings, ou comment mettre en place une stratégie fiable, scientifique et performante en peu de temps !

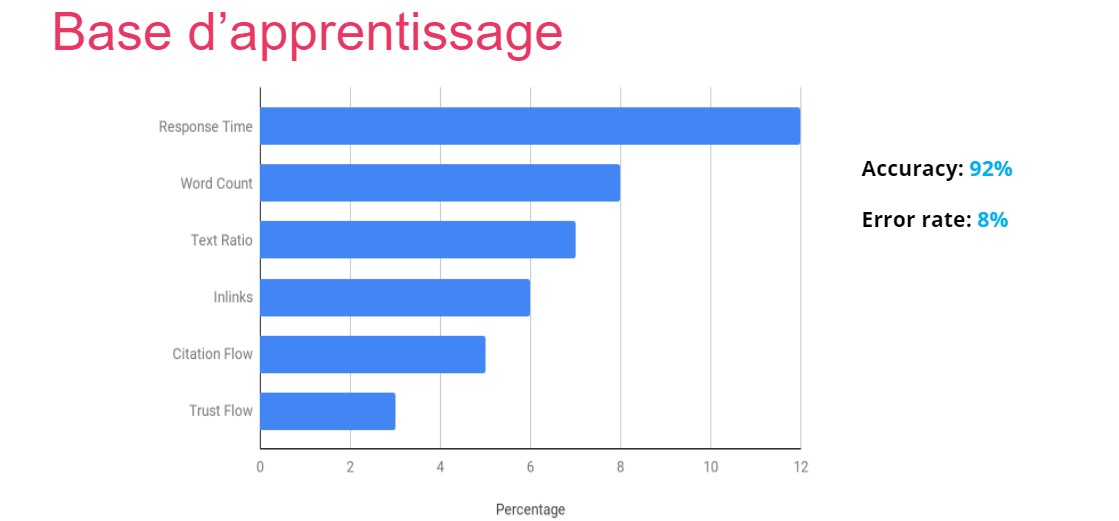

Uplix travaille donc actuellement sur un système de machine learning très performant, en collaboration avec Oncrawl. À partir d’une base d’apprentissage (un ensemble de données), il est capable d’estimer quels critères (ou features) dans un cas particulier, sont les plus importants, donc à prioriser (temps de chargement, le nombre de mots, etc.).

En somme, il lui suffit d’analyser un modèle de page d’après un certain nombre de critères, des datas et des statistiques. La valeur ajoutée de cet outil est donc une garantie mathématique de résultats, qui anticipe même sa marge d’erreur !

Comment savoir où je me place vis-à-vis de mes concurrents avec le Predictive SEO ?

En matière de predictive rankings, il nous faut faire face à un certain nombre de contraintes, afin d’établir un audit pertinent, aboutissant à des recommandations claires et bien fondées :

- la première a été de lister tous les features que nous connaissions afin de les implémenter à l’IA ;

- la deuxième est bien évidemment de collecter un maximum de données sur la page du site que l’on cherche à prédire. Et ce n’est pas tout : il s’agit d’obtenir également celles des sites concurrents (à savoir le top 10 des SERP, si ce n’est davantage). Il peut s’agir tout aussi bien de la performance que de la profondeur des pages, l’InRank, le contenu sémantique, la longueur des textes, etc. En conséquence, nous avons recours à plusieurs outils supplémentaires afin d’aller crawler les sites concurrents ;

- la troisième est de pouvoir effectuer une vérification des résultats avant de se lancer dans les recommandations ;

- la dernière est de convertir les prédictions en modèle explicable à nos clients. À ce titre, l’ambition est de créer des dashboards avec une interface d’aide à la décision, facilement utilisable et interprétable par tous les métiers afin de booster les ranks dans n’importe quel business.

Là serait alors la grande force du machine learning, à savoir prédire mais aussi expliquer les prédictions.

Le Predictive SEO pour identifier les actions à mener

Là est tout l’enjeu pour nous, et pour vous ! Ainsi, ULI est censé nous aider à :

- trouver les bonnes pages à ranker ;

- expliquer les mauvais scores ;

- grouper/filtrer les pages par segments, keywords ou encore features ;

- dresser un planning d’actions à court et long terme.

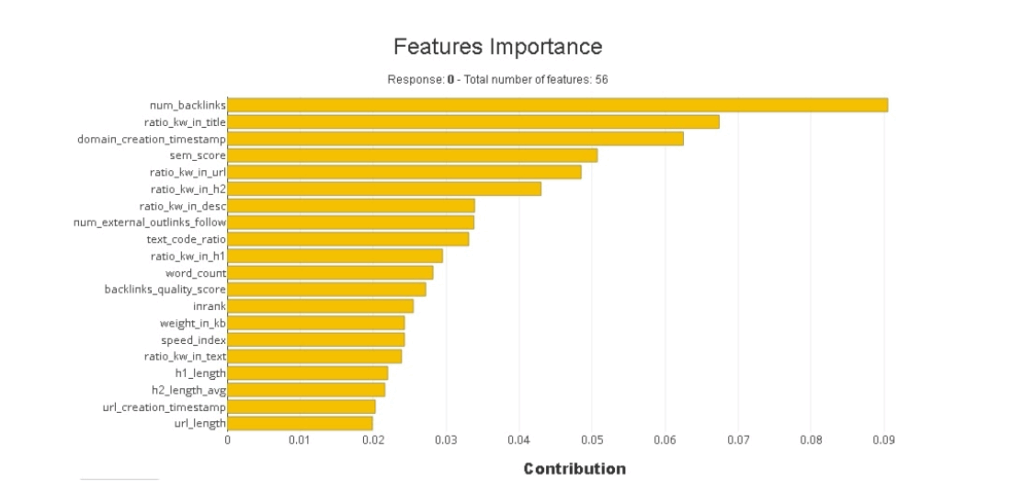

Ci-dessus, nous avons l’exemple d’un graphique illustrant le classement par ordre d’importance de 56 features favorisant une bonne position dans les résultats des moteurs de recherche. On observe donc, tout en haut, le poids des backlinks, suivi d’assez près par le nombre de mots-clés dans les titles.

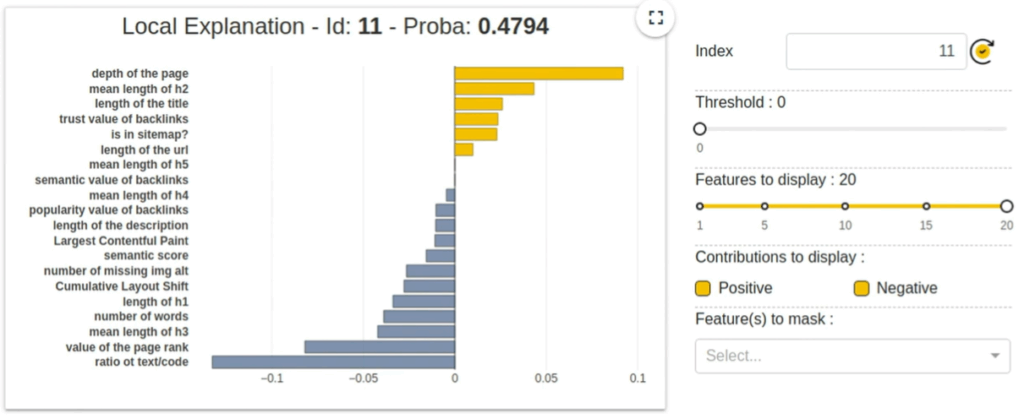

En troisième position, l’ancienneté du site, etc. Ci-dessous, une interface plus précise, qui montre également les features pénalisants pour une page isolée :

Une page avec beaucoup de contenu sera t’elle mieux positionnée dans Google ?

La réponse scientifique :

Il semblerait que cette page manque un peu de contenu textuel, comme l’illustre la dernière des barres bleues. À l’inverse, la profondeur de la page est un facteur valorisant dans ce cas particulier.

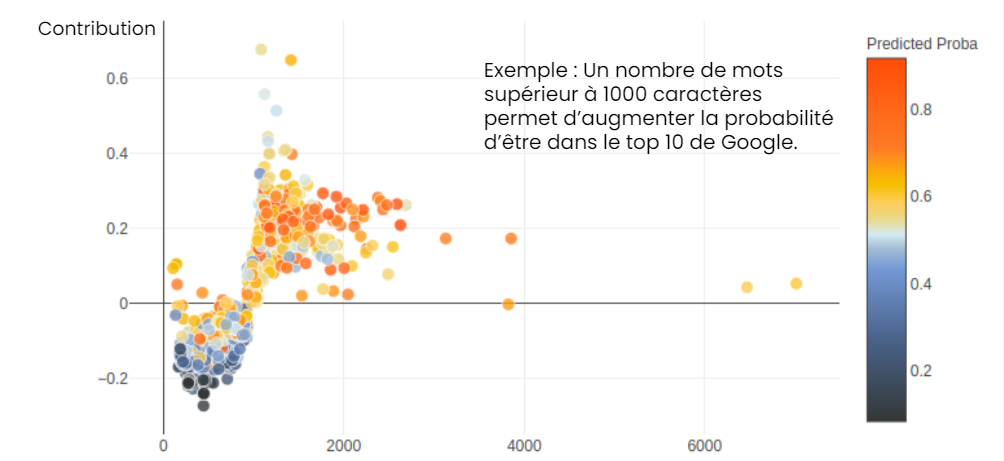

Mieux vaut donc ne pas la modifier ! Pareillement, le graphique ci-dessous nous indique que les pages les mieux classées dans les SERP sont souvent celles qui ont le plus de contenu :

Les points tirant sur le orange représentent les pages ayant le plus gros volume de contenu. On les voit se positionner relativement haut sur le graphique, tandis que les points bleus-gris, avec moins de matière, ont bien plus de mal à ranker.

Certes, il existe bien quelques contre-exemples avec des contenus assez peu importants qui rankent bien. Cela peut être dû à d’autres facteurs tels que la profondeur des pages (à savoir le nombre de clics nécessaires pour y parvenir). Mais dans l’ensemble, si vous enrichissez le contenu des pages correspondant aux points les plus bas, vous augmentez grandement vos chances d’avoir un meilleur positionnement dans les SERP !

Uplix Lab IA : en voie de révolutionner le Predictive Rankings ?

On l’espère ! Avec un tel outil, il devient possible de mesurer précisément l’écart qui existe entre un site web et sa concurrence. On devient capable de dire si une page gagne en ranking grâce à son Trustflow, la quantité de contenu proposé, etc. On peut alors prioriser les tâches et donc ajuster le budget des entreprises lorsqu’elles font appel à des agences SEO, à court et long terme. Quant à l’utilisateur, il risque de voir fleurir toujours plus de sites d’excellente qualité, toujours plus pertinents vis-à-vis de ses requêtes, grâce aux recommandations conformes aux règles de Google !

Vos questions, nos réponses !

Comment le predictive rankings d’Uplix Lab IA parvient-il à estimer le poids de chaque feature ?

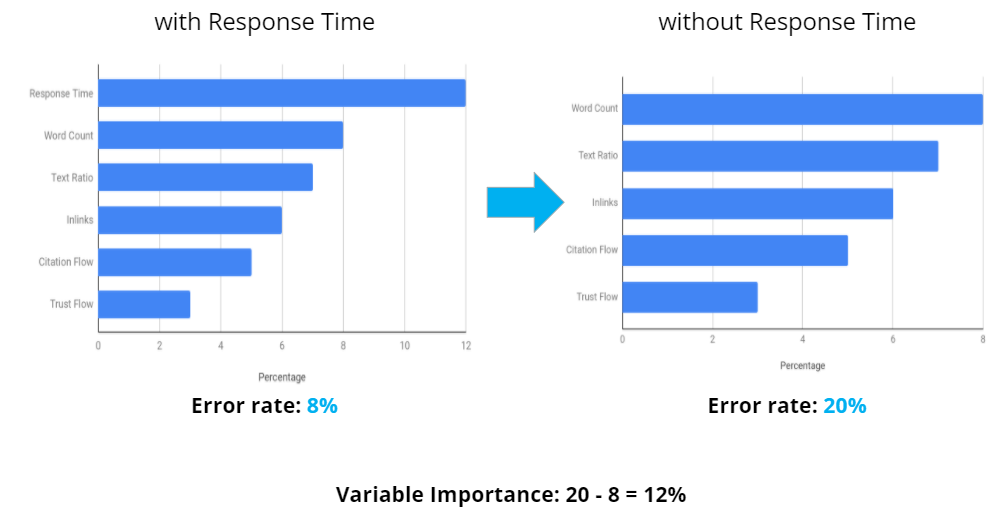

En fait, c’est tout simple ! ULI effectue lui-même des manipulations comme retirer un critère et voir combien son taux d’erreur augmente. Par exemple : on enlève le critère du temps de chargement, et le taux d’erreur passe de 8% à 20% ! Cette augmentation de 12% prouve – sans grande surprise en l’occurrence – que le temps de chargement est un facteur crucial de ranking.

Comment être certain.es que l’IA de Predictive Rankings ne se trompe pas ?

Certes, nous l’avons vu, l’humain a de bonnes intuitions, mais avec des intelligences artificielles, on gagne en précision, et on sait même à quel point chaque résultat est fiable. En effet, la plupart du temps, la machine de predictive SEO dépasse le seuil des 90%, atteignant même les 92%. Et pour la vérification, il suffit de taper le (ou les) bon(s) mots-clé(s) sur Google afin de comparer les résultats !

Quant à la marge d’erreur, elle concerne en réalité des facteurs imprédictibles, comme une pénalité manuelle, l’arrivée impromptue d’un concurrent, l’historique des internautes ou encore leur comportement (que nous pensons observé et rapporté par les navigateurs tels que Chrome. Cependant, la question est encore loin de faire consensus).

Qui pourra utiliser le Predictive Rankings ?

N’importe quel site web qui peine avec la concurrence SEO (voire SEA) pourra avoir un intérêt à utiliser de predictive rankings d’Uplix Lab IA. Soit pour optimiser petit à petit tous les facteurs de ranking par ordre d’importance, soit pour identifier un problème qui plombe le site, soit, enfin, pour booster un site à des périodes stratégiques dans le cadre du business qui lui est associé.

Retrouvez quels sont les meilleurs outils en SEO dans notre article complet sur la question.